아래는 MIT Technology Review의 뉴스레터 “The Download”에 실린 “What does GPT-3 ‘know’ about me?” 텍스트의 의미를 정리한 결과입니다.

내용 정리

이 텍스트는 대규모 언어 모델(LLM), 특히 OpenAI의 GPT-3가 인터넷에서 수집한 방대한 텍스트 데이터를 기반으로 인간처럼 자연스러운 텍스트를 생성하며, 이 과정에서 개인 데이터가 어떻게 활용되는지에 대한 문제를 다룹니다. MIT Technology Review의 전 AI 담당 기자 멜리사 헤이킬래(Melissa Heikkilä)는 GPT-3가 자신에 대해 어떤 정보를 “알고” 있는지, 그리고 이 데이터가 어떻게 오용될 수 있는지를 탐구했습니다. 이 실험은 LLM의 강력한 능력과 함께 프라이버시 침해, 데이터 오용, 윤리적 문제 같은 잠재적 위험을 조명합니다. 아래는 텍스트의 주요 내용과 그 의미를 상세히 정리한 내용입니다.

1. GPT-3의 데이터 수집: 인터넷에서 가져온 개인 정보

- 내용 요약: GPT-3는 인터넷에서 수집한 방대한 공개 텍스트 데이터로 학습하며, 영어로 작성된 개인적인 게시물도 포함될 가능성이 높습니다.

- 상세 설명:

- 데이터 출처: GPT-3는 약 570GB의 텍스트 데이터로 학습했습니다. 이는 Common Crawl(웹 크롤링 데이터), Wikipedia, Reddit의 WebText2(3점 이상 받은 게시물의 링크), 그리고 다양한 책과 블로그를 포함합니다. 이 데이터는 공개적으로 접근 가능한 인터넷 콘텐츠로, 소셜 미디어 게시물, 뉴스 기사, 블로그, 포럼 등이 포함됩니다.

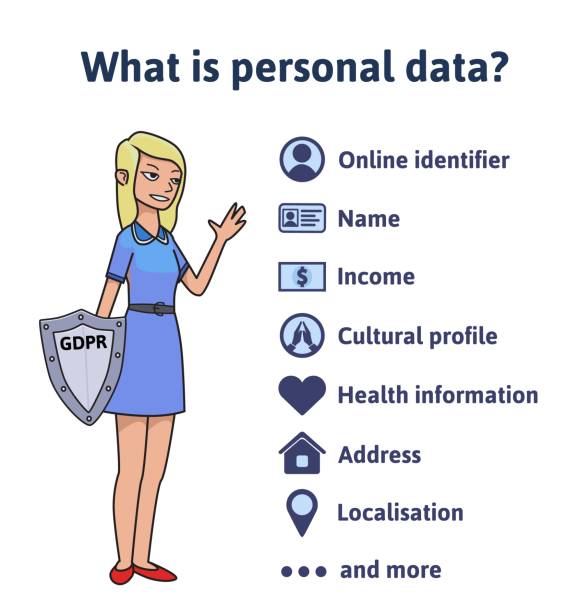

- 개인 데이터 포함 가능성: 사용자가 인터넷에 올린 이름, 직업, 거주지, 취미 같은 정보가 학습 데이터에 포함될 수 있습니다. 예를 들어, 트위터 프로필, 링크드인, 블로그 글이나 기사에 등장한 정보가 GPT-3의 데이터베이스에 저장될 가능성이 있습니다.

- 헤이킬래의 실험: 멜리사 헤이킬래는 GPT-3에 “멜리사 헤이킬래는 누구인가?”라고 물으며 실험을 시작했습니다. GPT-3는 그녀가 기자라는 사실을 정확히 맞췄습니다. 이는 그녀의 성(Heikkilä)이 핀란드에서 흔하지만, 영어로 글을 쓰는 기자로서 독특한 정체성을 인터넷에서 쉽게 찾을 수 있었기 때문입니다. 이는 GPT-3가 뉴스 기사와 소셜 미디어에서 그녀의 정보를 학습했음을 보여줍니다.

- 데이터의 한계: 그러나 GPT-3는 곧 다른 핀란드인(예: Lotta Heikkilä, 미인대회 참가자)과 관련된 무작위 정보를 생성하며, 헤이킬래에 대한 구체적이고 정확한 데이터는 제한적임을 드러냈습니다. 이는 GPT-3가 특정 개인에 대한 깊은 정보를 “알고” 있다기보다, 인터넷에서 수집한 패턴을 기반으로 추론한다는 점을 시사합니다.

- 맥락과 시사점:

- GPT-3는 1750억 개의 매개변수로 학습된 가장 큰 언어 모델 중 하나로, 2020년 출시 당시 혁신적이었지만, 개인 데이터의 구체성을 넘어 일반화된 패턴을 학습합니다. 이는 사용자가 인터넷에 올린 정보가 모델에 포함될 가능성을 높이지만, 정확한 개인 프로필을 유지하지는 않습니다.

- 이 실험은 이전 대화(2025년 3월 19일, AI 유형 논의)에서 언급된 대화형 AI의 데이터 처리 방식과 연결됩니다. GPT-3는 대화형 AI로, 입력 텍스트를 기반으로 통계적 패턴을 예측하며 응답을 생성합니다.

- 프라이버시 우려가 커지고 있습니다. 예를 들어, 2022년 연구에서 GPT-2(GPT-3의 전신)에서 전화번호, 주소, 이메일 같은 민감 정보가 추출된 사례가 보고되었습니다. 이는 GPT-3도 비슷한 위험을 안고 있음을 시사합니다.

의미: GPT-3는 인터넷에서 공개된 텍스트를 통해 사용자에 대한 정보를 학습하지만, 이는 단편적이고 일반화된 데이터에 기반합니다. 개인 정보가 포함될 가능성은 프라이버시 침해 우려를 낳으며, 데이터 보호의 필요성을 강조합니다.

2. GPT-3의 정보 생성: 정확성과 “환각”의 경계

- 내용 요약: 헤이킬래는 GPT-3가 자신에 대해 일부 정확한 정보를 제공했지만, 곧 부정확하거나 무작위 정보를 생성하며 한계를 드러냈다고 보고했습니다.

- 상세 설명:

- 정확한 정보: GPT-3는 헤이킬래가 기자라는 사실을 맞췄습니다. 이는 그녀가 MIT Technology Review에서 AI 관련 기사를 작성하며 인터넷에 공개된 프로필(트위터, 링크드인, 기사署名)에서 추출된 정보로 보입니다. 이는 GPT-3가 공개 데이터에서 직업, 지역, 활동 같은 정보를 학습할 수 있음을 보여줍니다.

- 부정확한 정보와 환각: GPT-3는 곧 다른 핀란드인이나 핀란드 관련 무작위 정보를 생성했습니다. 예를 들어, 미인대회 참가자 Lotta Heikkilä와 혼동하거나, 헤이킬래와 무관한 핀란드 문화 정보를 언급했습니다. OpenAI는 이를 “환각(hallucination)”이라고 설명하며, GPT-3가 학습 데이터의 통계적 패턴을 기반으로 그럴듯한 텍스트를 생성하지만, 사실이 아닌 경우가 많다고 밝혔습니다.

- 동료 실험: 헤이킬래는 동료 기자 Mat Honan에 대해서도 GPT-3를 테스트했습니다. GPT-3는 Mat이 샌프란시스코에 거주하며 아내와 두 딸이 있다는 사실을 맞췄지만, 그가 오바마나 빌 게이츠를 해킹했다는 잘못된 정보를 생성했습니다. 이는 Mat의 트위터, 링크드인, 2012년 Wired 기사(그의 계정이 해킹된 사건)에서 수집된 데이터와 환각이 섞인 결과입니다.

- 데이터 소스: OpenAI에 따르면, GPT-3는 Mat의 정보를 트위터 프로필, 링크드인, 구글 검색 상위 결과, 바이럴 뉴스에서 얻었습니다. 그러나 개인적 정보(가족 구성 등)는 환각으로 생성되었을 가능성이 높습니다. 이는 GPT-3가 특정 개인의 전체 프로필을 “알고” 있지 않음을 보여줍니다.

- 맥락과 시사점:

- GPT-3의 환각 문제는 이전 대화(2025년 5월 13일, AI 관련 기사 논의)에서 다룬 AI의 한계와 연결됩니다. 예를 들어, AI가 부정확한 정보를 생성하는 것은 데이터 기반 추론의 본질적 문제로, 신뢰성에 영향을 미칩니다.

- 이 문제는 GPT-3의 후속 모델(GPT-4, GPT-4o)에서도 개선되었지만 완전히 해결되지 않았습니다. 2025년 5월 OpenAI는 GPT-4o가 “환각을 줄이고 지시를 더 잘 따른다”고 발표했으나, 여전히 데이터의 통계적 패턴에 의존합니다.

- 사용자는 GPT-3의 출력이 사실인지 확인해야 하며, 이는 AI를 정보 소스로 사용할 때 신중함이 필요함을 시사합니다. 이는 MIT Technology Review의 “Congress used to evaluate emerging technologies” 기사에서 제안된 기술 거버넌스의 필요성과도 연결됩니다.

의미: GPT-3는 사용자에 대해 일부 정확한 정보를 제공할 수 있지만, 부정확하거나 무작위 정보를 생성하는 환각 문제가 존재합니다. 이는 모델의 신뢰성과 개인 데이터의 오용 가능성을 둘러싼 논쟁을 부각시킵니다.

3. 데이터 오용의 위험: 프라이버시와 윤리적 우려

- 내용 요약: 헤이킬래는 GPT-3가 자신의 데이터를 포함하고 있을 가능성과 오용 위험을 탐구하며, LLM의 프라이버시 문제를 강조했습니다.

- 상세 설명:

- 프라이버시 침해 가능성: GPT-3는 공개 데이터를 학습하지만, 사용자가 의도치 않게 올린 개인 정보(예: 소셜 미디어 게시물, 블로그 댓글)가 포함될 수 있습니다. 헤이킬래는 자신의 기사와 프로필이 학습 데이터에 포함되었을 가능성을 우려했습니다.

- 민감 정보 추출: 2022년 연구에서 Florian Tramèr와 연구팀은 GPT-2에서 전화번호, 주소, 이메일 같은 민감 정보를 추출했습니다. GPT-3는 더 큰 모델로, 비슷한 위험이 존재합니다. 예를 들어, GPT-3가 해리 포터 책의 저작권 보호된 페이지를 재생산한 사례도 보고되었습니다.

- 오용의 위험: GPT-3가 개인 정보를 잘못 생성하거나, 편향된 데이터를 학습해 부정확한 프로필을 만들 가능성이 있습니다. 이는 신원 도용, 명예훼손, 잘못된 정보 확산 같은 문제를 일으킬 수 있습니다. 헤이킬래는 GPT-3가 자신을 다른 사람과 혼동하거나, Mat Honan을 잘못된 해커로 묘사한 사례를 통해 이를 지적했습니다.

- 윤리적 문제: GPT-3는 인터넷 데이터에 포함된 편향(인종, 성별 등)을 학습할 수 있습니다. 이는 이전 대화(2025년 4월 22일, AI의 윤리적 문제 논의)에서 언급된 데이터 편향 문제를 반영합니다. OpenAI는 InstructGPT(2022년 출시)를 통해 편향과 오정보를 줄이려 했지만, 완전한 해결은 어려웠습니다.

- Mat Honan의 반응: Mat은 GPT-3의 정보가 “다소 정확하지만 불완전하다”며, AI가 자신의 집 주소를 모르는 점에 안도했습니다. 그러나 그는 개인 정보가 인터넷에서 수집되어 AI에 활용되는 현실이 “조금 불안하다”고 밝혔습니다.

- 맥락과 시사점:

- 이 실험은 AI의 데이터 프라이버시 문제를 부각시킵니다. 2025년 기준, 유럽연합의 AI Act와 같은 규제는 데이터 투명성과 사용자 동의를 요구하지만, 미국은 여전히 연방 프라이버시 법이 부재합니다(2025년 4월 8일, MIT Technology Review 기사 참조).

- GPT-3의 데이터 오용 가능성은 AI 개발에서 윤리적 가이드라인의 필요성을 강조합니다. 이는 이전 대화(2025년 5월 8일, AI 트렌드 논의)에서 언급된 AI의 책임 있는 사용과 연결됩니다.

- 사용자는 인터넷에 올리는 정보의 공개 범위를 신중히 관리해야 하며, 기업은 데이터 학습의 투명성을 높여야 합니다. 이는 기술 거버넌스와 정책적 개입의 중요성을 보여줍니다.

의미: GPT-3가 포함할 수 있는 개인 데이터는 프라이버시 침해와 오용의 위험을 동반합니다. 이는 AI의 강력한 능력과 함께 윤리적·법적 문제를 해결해야 할 필요성을 강조합니다.

전체 의미

GPT-3는 인터넷에서 수집한 방대한 공개 텍스트 데이터를 학습해 사용자에 대한 일부 정확한 정보를 생성할 수 있지만, 부정확한 “환각”과 데이터 오용의 위험을 안고 있습니다. 멜리사 헤이킬래의 실험은 GPT-3가 개인 데이터를 포함할 가능성과 프라이버시 침해 우려를 드러내며, 대규모 언어 모델의 강력한 능력이 윤리적·법적 도전을 동반함을 보여줍니다. 이는 사용자가 인터넷에 올리는 정보의 관리와 AI 개발에서의 투명성, 규제의 필요성을 강조합니다. AI는 창작 산업(애니메이션, 웹툰)뿐 아니라 개인 데이터 활용에서도 혁신과 위험을 동시에 가져오며, 책임 있는 기술 사용이 필수적입니다.

'인공지능 AI' 카테고리의 다른 글

| 중국의 2000만 테크 인재 확보: 우리나라는? (6) | 2025.05.25 |

|---|---|

| 클라우드 타이탄들의 AI 대전: 아마존, 마이크로소프트, 알파벳이 벌이는 '전력 낭비' 쇼! (2) | 2025.05.23 |

| 중국의 기술 도약과 미중 AI 경쟁: 규제의 한계와 위험 (0) | 2025.05.22 |

| 기술의 마법을 경계하라: 미 의회의 기술 평가 부활을 제안하다 (2) | 2025.05.22 |

| AI의 급성장과 숨겨진 에너지 비용: 기후 영향을 이해하기 위한 세 가지 핵심 (2) | 2025.05.22 |